ТРАНСФОРМАТОРЫ. РАСШИФРОВКА НАИМЕНОВАНИЙ

Наименование (а точнее, номенклатура) трансформатора, говорит о его конструктивных особенностях и параметрах. При умении читать наименование оборудования можно только по нему узнать количество обмоток и фаз силового трансформатора, тип охлаждения, номинальную мощность и напряжение высшей обмотки.

ОБЩИЕ РЕКОМЕНДАЦИИНоменклатура трансформаторов (расшифровка буквенных и цифровых обозначений наименования) не регламентируется какими-либо нормативными документами, а всецело определяется производителем оборудования. Поэтому, если название Вашего трансформатора не поддаётся расшифровке, то обратитесь к его производителю или посмотрите паспорт изделия. Приведенные ниже расшифровки букв и цифр названия трансформаторов актуальны для отечественных изделий.

Наименование трансформатора состоит из букв и цифр, каждая из которых имеет своё значение. При расшифровке наименования следует учитывать то что некоторые из них могут отсутствовать в нём вообще (например буква «А» в наименовании обычного трансформатора), а другие являются взаимоисключающими (например, буквы «О» и «Т»).

Для силовых трансформаторов приняты следующие буквенные обозначения:

Таблица 1 — Расшифровка буквенных и цифровых обозначений наименования силового трансформатора

Примечание: принудительная циркуляция воздуха называется дутьем, то есть «с принудительной циркуляцией воздуха» и «с дутьем» равнозначные выражения.

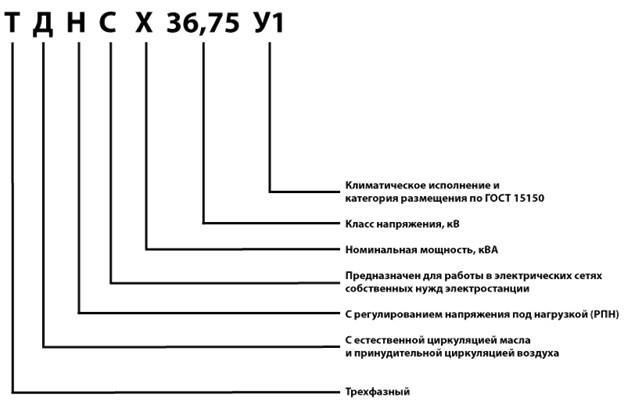

ПРИМЕРЫ РАСШИФРОВКИ НАИМЕНОВАНИЙ СИЛОВЫХ ТРАНСФОРМАТОРОВ

ТМ — 100/35 — трансформатор трёхфазный масляный с естественной циркуляцией воздуха и масла, номинальной мощностью 0,1 МВА, классом напряжения 35 кВ;

ТДНС — 10000/35 — трансформатор трёхфазный с дутьем масла, регулируемый под нагрузкой для собственных нужд электростанции, номинальной мощностью 10 МВА, классом напряжения 35 кВ;

ТРДНФ — 25000/110 — трансформатор трёхфазный, с расщеплённой обмоткой, масляный с принудительной циркуляцией воздуха, регулируемый под нагрузкой, с расширителем, номинальной мощностью 25 МВА, классом напряжения 110 кВ;

АТДЦТН — 63000/220/110 — автотрансформатор трёхфазный, масляный с дутьём и принудительной циркуляцией масла, трёхобмоточный, регулируемый под нагрузкой, номинальной мощностью 63 МВА, класс ВН — 220 кВ, класс СН — 110 кВ;

АОДЦТН — 333000/750/330 — автотрансформатор однофазный, масляный с дутьём и принудительной циркуляцией масла, трёхобмоточный, регулируемый под нагрузкой, номинальной мощностью 333 МВА, класс ВН — 750 кВ, класс СН — 500 кВ.

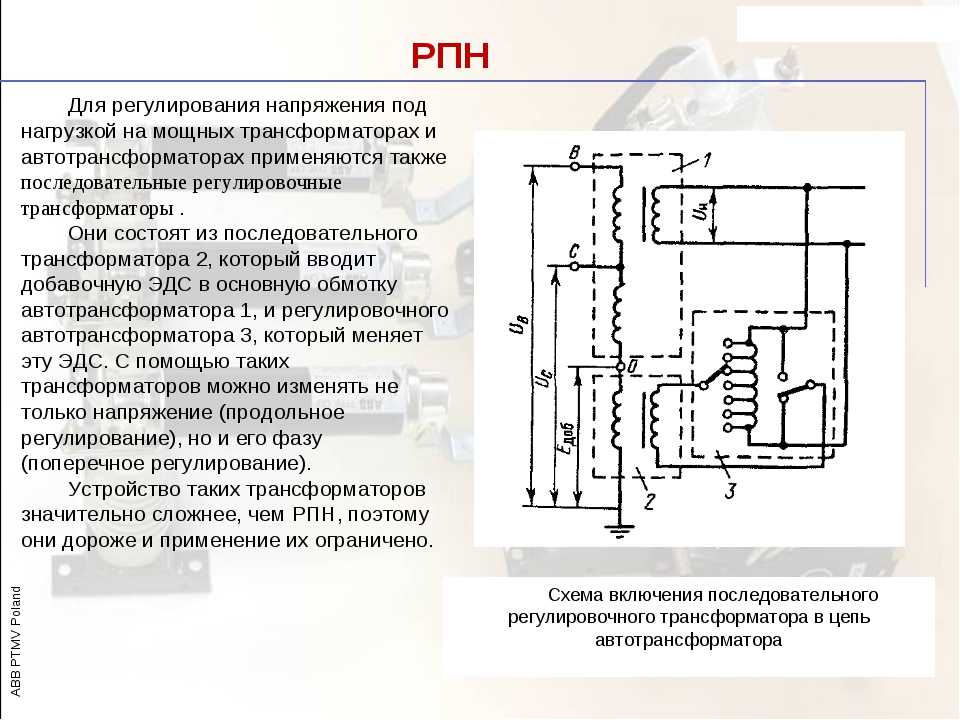

Для регулировочных трансформаторов приняты следующие сокращения:

Таблица 2 — Расшифровка буквенных и цифровых обозначений наименования регулировочного трансформатора

ПРИМЕРЫ РАСШИФРОВКИ НАИМЕНОВАНИЙ РЕГУЛИРОВОЧНЫХ ТРАНСФОРМАТОРОВ

ВРТДНУ — 180000/35/35 — трансформатор вольтодобавочный, регулировочный, трёхфазный, с масляным охлаждением типа Д, регулируемый под нагрузкой, с усиленным вводом, проходной мощностью 180 МВА, номинальное напряжение обмотки возбуждения 35 кВ, номинальное напряжения регулировочной обмотки 35 кВ;

ЛТМН — 160000/10 — трансформатор линейный, трёхфазный, с естественной циркуляцией масла и воздуха, регулируемый под нагрузкой, проходной мощностью 160 МВА, номинальным линейным напряжением 10 кВ.

РАСШИФРОВКА НАИМЕНОВАНИЙ ТРАНСФОРМАТОРОВ НАПРЯЖЕНИЯ

Для трансформаторов напряжения приняты следующие сокращения:

Таблица 3 — Расшифровка буквенных и цифровых обозначений наименования трансформатора напряжения

Примечание:

Комплектующий для серии НОСК;

С компенсационной обмоткой для серии НТМК;

Кроме серии НОЛ и ЗНОЛ, в которых:

— 06 — для встраивания в закрытые токопроводы, ЗРУ и КРУ внутренней установки;

— 08 — для ЗРУ и КРУ внутренней и наружной установки;

— 11 — для взрывоопасных КРУ.

ПРИМЕРЫ РАСШИФРОВКИ НАИМЕНОВАНИЙ ТРАНСФОРМАТОРОВ НАПРЯЖЕНИЯ

НОСК-3-У5 — трансформатор напряжения однофазный с сухой изоляцией, комплектующий, номинальное напряжение обмотки ВН 3 кВ, климатическое исполнение — У5;

НОМ-15-77У1 — трансформатор напряжения однофазный с масляной изоляцией, номинальное напряжение обмотки ВН 15 кВ, 1977 года разработки, климатическое исполнение — У1;

ЗНОМ-15-63У2 — трансформатор напряжения с заземляемым концом обмотки ВН, однофазный с масляной изоляцией, номинальное напряжение обмотки ВН 15 кВ, 1963 года разработки, климатическое исполнение — У2;

ЗНОЛ-06-6У3 — трансформатор напряжения с заземляемым концом обмотки ВН, однофазный с литой эпоксидной изоляцией, для встраивания в закрытые токопроводы, ЗРУ и КРУ внутренней установки, климатическое исполнение — У3;

НТС-05-УХЛ4 — трансформатор напряжения трёхфазный с сухой изоляцией, номинальное напряжение обмотки ВН 0,5 кВ, климатическое исполнение — УХЛ4;

НТМК-10-71У3 — трансформатор напряжения трёхфазный с масляной изоляцией и компенсационной обмоткой, номинальное напряжение обмотки ВН 10 кВ, 1971 года разработки, климатическое исполнение — У3;

НТМИ-10-66У3 — трансформатор напряжения трёхфазный с масляной изоляцией и обмоткой для контроля изоляции сети, номинальное напряжение обмотки ВН 10 кВ, 1966 года разработки, климатическое исполнение — У3;

НКФ-110-58У1 — трансформатор напряжения каскадный в фарфоровой покрышке, номинальное напряжение обмотки ВН 110 кВ, 1958 года разработки, климатическое исполнение — У1;

НДЕ-500-72У1 — трансформатор напряжения с ёмкостным делителем, номинальное напряжение обмотки ВН 500 кВ, 1972 года разработки, климатическое исполнение — У1;

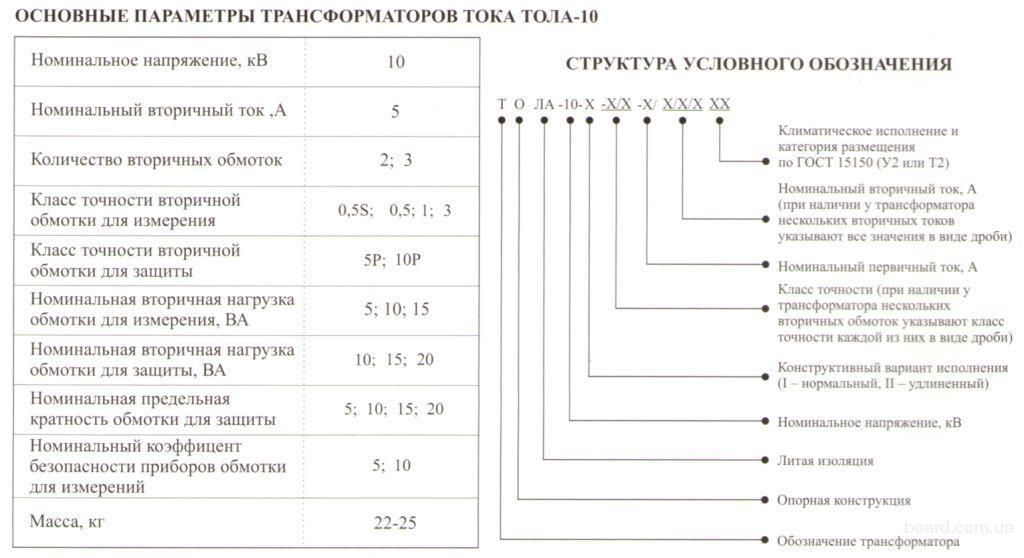

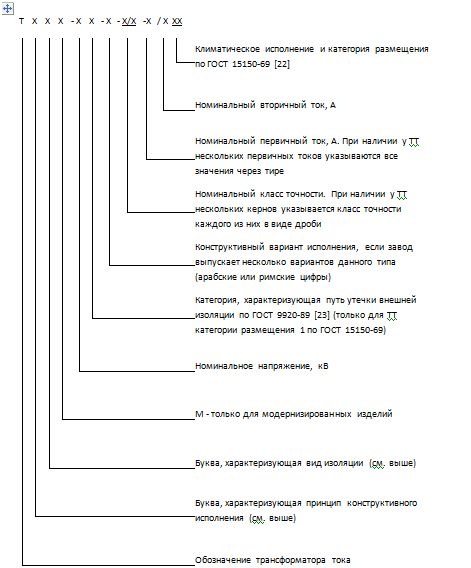

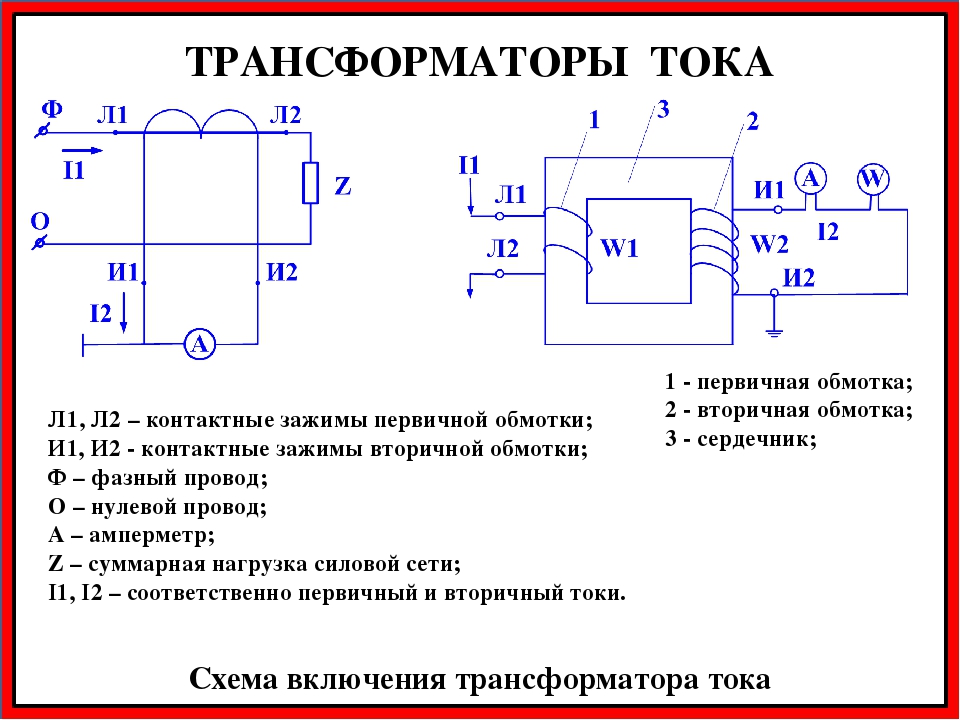

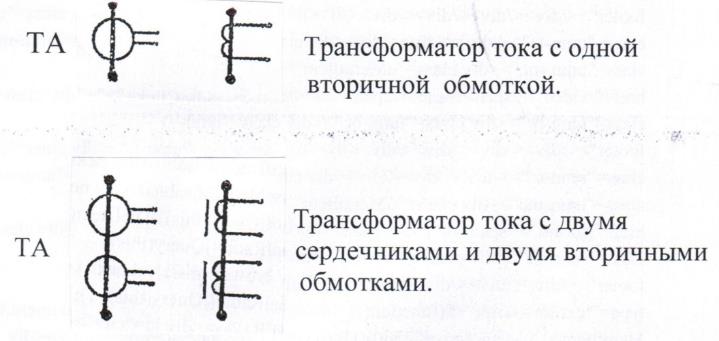

РАСШИФРОВКА НАИМЕНОВАНИЙ ТРАНСФОРМАТОРОВ ТОКА

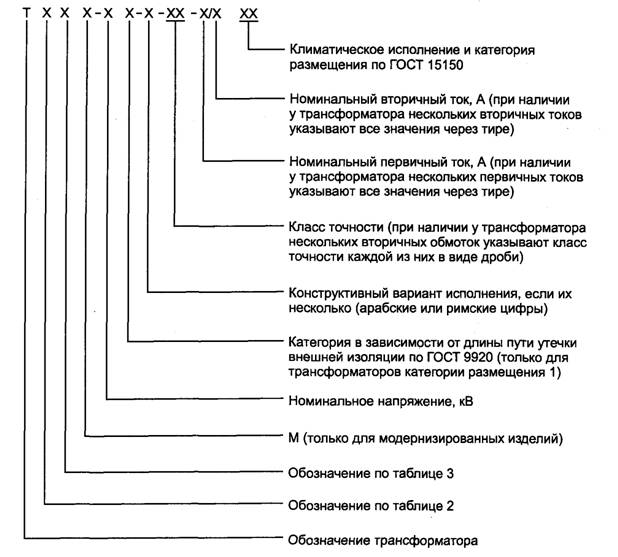

Для трансформаторов тока приняты следующие сокращения:

Таблица 4 — Расшифровка буквенных и цифровых обозначений наименования трансформатора тока

Примечание:

Для серии ТВ, ТВТ, ТВС, ТВУ;

Для серии ТНП, ТНПШ — с подмагничиванием переменным током;

Для серии ТШВ, ТВГ;

Для ТВВГ — 24 — водяное охлаждение;

Для серии ТНП, ТНПШ;

Для серии ТВ, ТВТ, ТВС, ТВУ — номинальное напряжения оборудования;

Для серии ТНП, ТНПШ — число обхватываемых жил кабеля;

Для серии ТНП, ТНПШ — номинальное напряжение.

ПРИМЕРЫ РАСШИФРОВКИ НАИМЕНОВАНИЙ ТРАНСФОРМАТОРОВ ТОКА

ТФЗМ — 35А — У1 — трансформатор тока в фарфоровой покрышке, с обмоткой звеньевого исполнения, с масляной изоляцией, номинальным напряжением обмотки ВН 35 кВ, категории А, климатическим исполнением У1;

ТФРМ — 750М — У1 — трансформатор тока в фарфоровой покрышке, с обмоткой рымочного исполнения, с масляной изоляцией, номинальным напряжением обмотки ВН 750 кВ, климатическим исполнением У1;

ТШЛ — 10К — трансформатор тока шинный с литой изоляцией, номинальное напряжением обмотки ВН 10 кВ;

ТЛП — 10К — У3 — трансформатор тока с литой изоляцией, проходной, номинальным напряжением обмотки ВН 10 кВ, климатическое исполнение — У3;

ТПОЛ — 10 — трансформатор тока проходной, одновитковый, с литой изоляцией, номинальным напряжением обмотки ВН 10 кВ;

ТШВ — 15 — трансформатор тока шинный, с воздушным охлаждением, номинальным напряжением обмотки ВН 15 кВ;

ТВГ — 20 — I — трансформатор тока с воздушным охлаждением, генераторный, номинальным напряжением обмотки ВН 20 кВ;

ТШЛО — 20 — трансформатор тока шинный, с литой изоляцией, одновитковый, номинальным напряжением обмотки ВН 20 кВ;

ТВ — 35 — 40У2 — трансформатор тока встроенный, номинальным напряжением обмотки ВН 35 кВ, током термической стойкости 40 кА, климатическое исполнение — У2;

ТНП — 12 — трансформатор тока нулевой последовательности, с подмагничиванием переменным током, охватывающий 12 жил кабеля;

ТНПШ — 2 — 15 — трансформатор тока нулевой последовательности, с подмагничиванием переменным током, шинный, охватывающий 2 жилы кабеля, номинальным напряжением обмотки ВН 15 кВ.

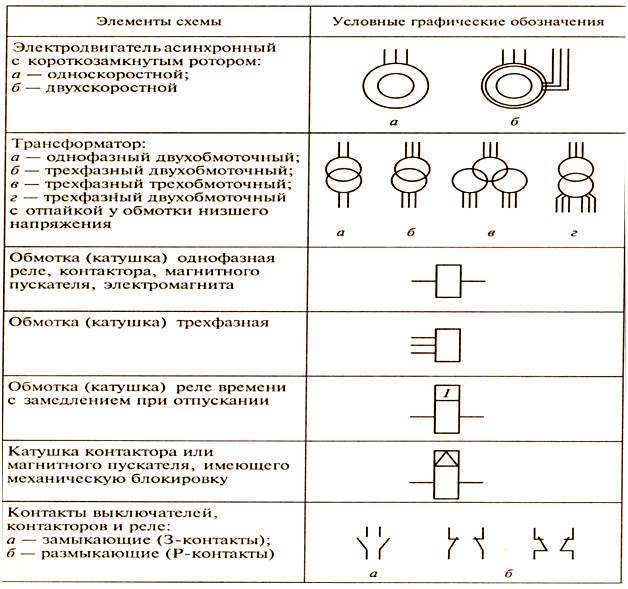

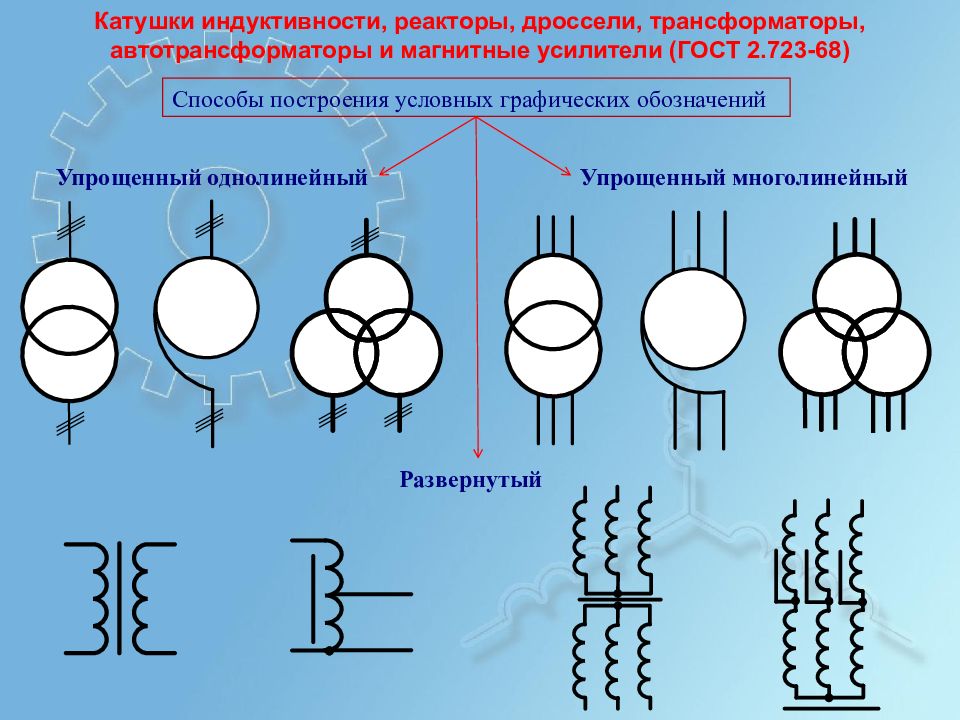

Трансформаторы — Буквенные обозначения трансформатора

БУКВЕННОЕ ОБОЗНАЧЕНИЕ СИЛОВОГО ТРАНСФОРМАТОРА

ОБЩЕГО И СПЕЦИАЛЬНОГО НАЗНАЧЕНИЯ

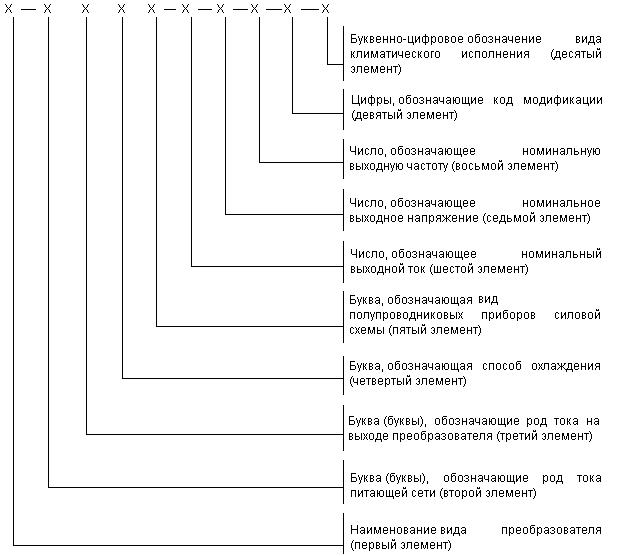

Схема буквенного обозначения типов трансформаторов:

Расшифровка буквенного обозначения силового трансформатора:

1 А – автотрансформатор (может отсутствовать)

2 Число фаз:

Т – трёхфазный

О – однофазный

3 Р – с расщеплённой обмоткой (может отсутствовать)

4 Условное обозначения вида охлаждения:

Масляные трансформаторы

М – естественная циркуляция воздуха и масла

Д — принудительная циркуляция воздуха и естественная циркуляция масла

МВ – с принудительной циркуляцией воды и естественной циркуляцией масла

МЦ — естественная циркуляция воздуха и принудительная циркуляция масла с ненаправленным потоком масла

НМЦ — Естественная циркуляция воздуха и принудительная циркуляция масла с направленным потоком масла

ДЦ – Принудительная циркуляция воздуха и масла с ненаправленным потоком масла

НДЦ — Принудительная циркуляция воздуха и масла с направленным потоком масла

Ц — Принудительная циркуляция воды и масла с ненаправленным потоком масла (в охладителях вода движется по трубам, а масло – в межтрубном пространстве, разделённом перегородками)

НЦ — Принудительная циркуляция воды и масла с направленным потоком масла

Трансформаторы с негорючим жидким диэлектриком

Н — Естественное охлаждение негорючим жидким диэлектриком

НД — Охлаждение негорючим жидким диэлектриком с принудительной циркуляцией воздуха

ННД — Охлаждение негорючим жидким диэлектриком с принудительной циркуляцией воздуха и с направленным потоком жидкого диэлектрика

Сухие трансформаторы

С — Естественное воздушное при открытом исполнении

СЗ — Естественное воздушное при защищенном исполнении

СГ — Естественное воздушное при герметичном исполнении

СД — Воздушное с принудительной циркуляцией воздуха

5 Т – трёхобмоточный трансформатор

6 Н – трансформатор с РПН (с регулированием напряжения под нагрузкой)

7 Особенность исполнения (в обозначении может отсутствовать):

В – с принудительной циркуляцией воды

Г – грозозащитное исполнение

Г – трансформатор в гофрированном баке без расширителя — «герметичное исполнение»

З – трансформатор с естественным масляным охлаждением или с охлаждением негорючим жидким диэлектриком с защитой при помощи азотной подушки, без расширителя и выводами,

смонтированными во фланцах на стенках бака

Л — исполнение трансформатора с литой изоляцией

П — подвесного исполнения на опоре ВЛ

У – усовершенствованное (может быть с автоматическим РПН)

У – трансформатор с симметрирующим устройством

Ф – трансформатор с расширителем и выводами, смонтированными во фланцах на стенках бака

э – трансформатор с пониженными потерями холостого хода (энергосберегающий)

8 Назначение (в обозначении может отсутствовать)

Б – для прогрева бетона или грунта в холодное время года (бетоногрейный), с такой же литерой может обозначаться трансформатор для буровых станков

Б – трансформатор для буровых станков

Ж – для электрификации железных дорог

М – для металлургического производства

П – для линий передачи постоянного тока

ПН – исполнение для питания погружных электронасосов

С – для собственных нужд электростанций (в конце буквенного обозначения)

ТО – для термической обработки бетона и грунта, питания ручного инструмента, временного освещения

Ш – шахтные трансформаторы (предназначены для электроснабжения угольных шахт стационарной установки)

Э – для питания электрооборудования экскаваторов (экскаваторный)

Примеры серий силовых трансформаторов общего назначения: TМ, ТМГ, ТМЭ, ТМЭГ, ТМБ, ТМПН, ТМВГ, ТМВЭГ, ТМВБГ, ТМЖ, ТМВЭ, ТМВБ, ТМЗ, ТМФ, ТМЭБ, ТМВМЗ, ТМС, ТСЗ, ТСЗС, ТРДНС, ТМН,

ТДНС, ТДН, ТМН, ТРДН, ТРДЦН

Примеры:

ТМ – Т – трансформатор трехфазный, М – с естественной циркуляцией воздуха и масла

ТМВГ – Т — трансформатор трехфазный, МВ — с естественной циркуляцией масла и принудительной циркуляцией воды, Г — в герметичном исполнении

ТНЗ – Т — трехфазный, Н — с регулированием под нагрузкой (РПН), З — с естественным масляным

ТМВМ – Т- трехфазный, МВ — с естественной циркуляцией масла и принудительной циркуляцией воды, М – для металлургического производства

ТМГ – Т — трехфазный, М — масляный, Г — в герметичном исполнении

ТМВГ – Т — трехфазный, МВ — с естественной циркуляцией масла и принудительной циркуляцией воды, Г — в герметичном исполнении

ТСЗ – Т — трехфазный, С — естественное воздушное охлаждение, З — в защищенном исполнении;

ТСЗС – Т — трехфазный, С — сухой, З — защищенное исполнение, С — для собственных нужд электростанций

Трехобмоточные: ТМТН, ТДТН, ТДЦТН

Т – стоящая после обозначения системы охлаждения обозначает – трехобмоточный.

Автотрансформаторы: АТДТНГ, АТДЦТНГ, АТДЦТН, АОДЦТН

А – автотрансформатор;

О – однофазный,

Г – грозоупорный.

ТМ 1000/10 74 У1 – Т- трехфазный двух обмоточный трансформатор, М – охлаждение естественная циркуляция воздуха и масла, номинальная мощность — 1000 кВА, класс высшего напряжения — 10 кВ, конструкция — 1974 г., У1 — для района с умеренным климатом, для установки на открытом воздухе;

ТРДНС 25000/35 74 Т1 трехфазный двух обмоточный трансформатор, с расщепленной обмоткой НН, с принудительной циркуляцией воздуха в системе охлаждения, с РПН, для собственных нужд электростанций, номинальная мощность 25 МВА, класс высшего напряжения 35 кВ, конструкция 1974 г., тропического исполнения, для установки на открытом воздухе;

ТЦ 1000000/500 83ХЛ1 трехфазный двух обмоточный трансформатор с принудительной циркуляцией масла и воды в системе охлаждения, номинальная мощность 1000 МВА, класс напряжения 500 кВ, конструкция 1983 г. , для районов с холодным климатом, для наружной установки.

, для районов с холодным климатом, для наружной установки.

Для автотрансформаторов при классах напряжения стороны СН (среднее напряжение) или НН (низкое напряжение) 110 кВ и выше после класса напряжения стороны ВН (высокое напряжение) через черту дроби указывают класс напряжения стороны СН или НН.

Примечание. Для трансформаторов, разработанных до 01.07.87, допускается указывать последние две цифры — год выпуска рабочих чертежей.

Автотрансформаторы отличаются добавлением к обозначению трансформаторов буквы А, она может быть первой в буквенном обозначении или последней.

В автотрансформаторах, изготовленных по основному стандарту трансформаторов ГОСТ 1167765, ГОСТ 1167775, ГОСТ 1167785, буква А стоит впереди всех символов

Например: АОДЦТН 417000/750/500 73У1 однофазный трехобмоточный автотрансформатор номинальной (проходной) мощностью 417 МВА, класс напряжения ВН 750 кВ, СН 500 кВ, остальные символы расшифровываются так же, как и в предыдущих примерах.

В конце 50х годов, когда в СССР впервые появились мощные силовые автотрансформаторы 220/110, 400/220, 400/110, 500/220, 500110 кВ, и в начале 60х годов производили автотрансформаторы двух модификаций повышающей и понижающей. В обозначении повышающей модификации буква А стояла в конце буквенной части; в этих автотрансформаторах обмотку НН выполняли на повышенную мощность и располагали между обмотками СН и ВН, по точной терминологии между общей и последовательной обмотками.

Автотрансформаторы второй модификации понижающей, с буквой А впереди всех символов (как и в новых автотрансформаторах) служат для понижения напряжения, например, с 220 до 110 кВ, или для связи сетей ВН и СН. Обмотка НН в них, как и в новых автотрансформаторах, расположена у стержня, имеет пониженную мощность и несет вспомогательные функции.

Пример обозначения повышающей модификации:

ТДШТА 120000/220, понижающей АТДШТ 120000/220. (Буква Г обозначала грозоупорный, но отменена по мере внедрения ГОСТ 1167765, так как все трансформаторы и автотрансформаторы 110 кВ и выше имеют гарантированную стойкость при грозовых перенапряжениях). В эксплуатации до сих пор встречаются автотрансформаторы обеих модификаций.

В эксплуатации до сих пор встречаются автотрансформаторы обеих модификаций.

ОСНОВНЫЕ ХАРАКТЕРИСТИКИ ТРАНСФОРМАТОРА (АВТОТРАНСФОРМАТОРА), УКАЗАННЫЕ НА ЗАВОДСКОМ ЩИТКЕ (ТАБЛИЧКЕ)

Щиток крепится к баку трансформатора, и указаны следующие параметры:

– тип трансформатора

– число фаз

– частота, Гц

– род установки (наружная или внутренняя)

– номинальная мощность, кВА, для трехобмоточных трансформаторов указывают мощность каждой обмотки

– схема и группа соединения обмоток

– напряжения на номинальной ступени и напряжения ответвлений обмоток, кВ

– номинальный ток, А

– напряжение короткого замыкания в процентах (фактически измеренное, для каждого изделия индивидуальное)

– способ охлаждения трансформатора

– полная масса трансформатора, масла и активной части трансформатора.

Маркировка трансформаторов: буквенно-цифровые обозначения

Трансформаторы уже давно нашли широкое применение в электронных и электронно-технических системах. Они зарекомендовали себя надежными устройствами в области преобразования тока и напряжения. Однако далеко не все знают, что означает та или иная маркировка трансформаторов, нанесенная на прибор. Знание условных обозначений, позволяет определить не только тип устройства, но и его основные технические характеристики.

Они зарекомендовали себя надежными устройствами в области преобразования тока и напряжения. Однако далеко не все знают, что означает та или иная маркировка трансформаторов, нанесенная на прибор. Знание условных обозначений, позволяет определить не только тип устройства, но и его основные технические характеристики.

Расшифровка буквенных символов

Основные марки трансформаторов представлены в виде буквенных обозначений и выглядят таким образом: ТМ, ТМЗ, ТСЗ, ТСЗС, ТРДНС, ТМН, ТДНС, ТДН, ТРДН, ТРДЦН.

Данные символы соответствуют следующим техническим характеристикам:

- Т – трехфазная конструкция устройства;

- Р – разделение обмотки низкого напряжения на две части;

- С – сухой тип трансформатора;

- М – наличие масляного охлаждения трансформатора, циркуляция воздуха и масло происходит естественным путем;

- Ц – в трансформаторах этого типа циркуляция воды и масла осуществляется принудительно. Движение воды происходит по трубам, а масло течет между ними в виде ненаправленного потока.

- МЦ – означает естественную циркуляцию воздуха в трансформаторе и принудительную циркуляцию масла с ненаправленным потоком;

- Д – соответствует масляному трансформатору с принудительной циркуляцией масла и естественной циркуляцией воздуха;

- ДЦ – относится к конструкции трансформатора с принудительной циркуляцией воздуха и масла в системе охлаждения;

- Н – регулировка напряжения устройства осуществляется под нагрузкой;

- С – если данная буква проставлена в конце маркировки, это указывает на использование трансформатора в самой электростанции.

- З – означает герметичную модель трансформатора, в котором имеется азотная подушка и отсутствует расширитель.

Прочие символы и обозначения

В маркировке трансформаторов присутствуют и другие символы, раскрывающие дополнительные технические характеристики того или иного устройства. Например, у трансформаторов с тремя обмотками в обозначении имеется еще одна буква Т, поэтому общая маркировка выглядит как ТМТН, ТДТН или ТДЦТН. Наличие буквы А указывает на автоматический тип устройства, а символ Г означает защиту от грозы, буква О – однофазную конструкцию.

Наличие буквы А указывает на автоматический тип устройства, а символ Г означает защиту от грозы, буква О – однофазную конструкцию.

Характерными особенностями силовых трансформаторов являются их номинальная мощность, класс напряжения, применяемый в работе, конструктивные особенности, условия и режим функционирования. Для более подробной расшифровки технических характеристик конкретного устройства существуют специальные таблицы.

В настоящее время выпускаются трансформаторы, которые могут работать в различных климатических условиях. Они могут быть установлены не только в специально оборудованных помещениях, но и на открытом воздухе. Поэтому, в соответствии со своим предназначением, все устройства делятся на специальные и общего назначения. Различия в системах охлаждения позволяют классифицировать их как сухие, масляные или с использованием жидкого негорючего диэлектрика.

Номинальная мощность и класс напряжения указываются после буквенных символов через дефис. Такая маркировка трансформаторов представляет собой обыкновенную дробь, где в числителе отображается значение номинальной мощности в киловаттах, а в знаменателе – класс напряжения в киловольтах.

Такая маркировка трансформаторов представляет собой обыкновенную дробь, где в числителе отображается значение номинальной мощности в киловаттах, а в знаменателе – класс напряжения в киловольтах.

Например, обозначение ТМ1000/1074 У1 указывает на три фазы, две обмотки и естественное масляное охлаждение. Значение номинальной мощности составляет 1000 кВА, класс напряжения – 10 кВ. Цифровое обозначение 74 соответствует году изготовления 1974. Агрегат может использоваться в умеренном климате с возможностью установки на открытом воздухе.

Трансформаторы. Расшифровка наименований. Примеры — Всё об энергетике

Трансформаторы. Расшифровка наименований. Примеры

Наименование (а точнее, номенклатура) трансформатора, говорит о его конструктивных особенностях и параметрах. При умении читать наименование оборудования можно только по нему узнать количество обмоток и фаз силового трансформатора, тип охлаждения, номинальную мощность и напряжение высшей обмотки.

При умении читать наименование оборудования можно только по нему узнать количество обмоток и фаз силового трансформатора, тип охлаждения, номинальную мощность и напряжение высшей обмотки.

Общие рекомендации

Номенклатура трансформаторов (расшифровка буквенных и цифровых обозначений наименования) не регламентируется какими-либо нормативными документами, а всецело определяется производителем оборудования. Поэтому, если название Вашего трансформатора не поддаётся расшифровке, то обратитесь к его производителю или посмотрите паспорт изделия. Приведенные ниже расшифровки букв и цифр названия трансформаторов актуальны для отечественных изделий.

Наименование трансформатора состоит из букв и цифр, каждая из которых имеет своё значение. При расшифровке наименования следует учитывать то что некоторые из них могут отсутствовать в нём вообще (например буква «А» в наименовании обычного трансформатора), а другие являются взаимоисключающими (например, буквы «О» и «Т»).

Расшифровка наименований силовых трансформаторов

Для силовых трансформаторов приняты следующие буквенные обозначения [1, c. 238]:

238]:

| 1. Автотрансформатор | А |

| 2. Число фаз | |

| Однофазный | О |

| Трёхфазный | Т |

| 3. С расщепленной обмоткой | Р |

| 4. Охлаждение | |

| Сухие трансформаторы: | |

| естественное воздушное при открытом исполнении | С |

| естественное воздушное при защищенном исполнении | СЗ |

| естественное воздушное при герметичном исполнении | СГ |

| воздушное с принудительной циркуляцией воздуха | СД |

| Масляные трансформаторы: | |

| естественная циркуляция воздуха и масла | М |

| принудительная циркуляция воздуха и естественная циркуляция масла | Д |

| естественная циркуляция воздуха и принудительная циркуляция масла с ненаправленным потоком масла | МЦ |

| естественная циркуляция воздуха и принудительная циркуляция масла с направленным потоком масла | НМЦ |

| принудительная циркуляция воздуха и масла с ненаправленным потоком масла | ДЦ |

| принудительная циркуляция воздуха и масла с направленным потоком масла | НДЦ |

| принудительная циркуляция воды и масла с ненаправленным потоком масла | Ц |

| принудительная циркуляция воды и масла с направленным потоком масла | НЦ |

5. Трёхобмоточный Трёхобмоточный | Т |

| 6. Переключение ответвлений | |

| регулирование под нагрузкой (РПН) | Н |

| автоматическое регулирование под нагрузкой (АРПН) | АН |

| 7. С литой изоляцией | Л |

| 8. Исполнение расширителя | |

| с расширителем | Ф |

| без расширителя, с защитой при помощи азотной подушки | З |

| без расширителя в гофробаке (герметичная упаковка) | Г |

| 9. С симметрирующим устройством | У |

| 10. Подвесного исполнения (на опоре ВЛ) | П |

| 11. Назначение | |

| для собственных нужд электростанций | С |

| для линий постоянного тока | П |

| для металлургического производства | М |

| для питания погружных электронасосов | ПН |

| для прогрева бетона или грунта (бетоногрейный), для буровых станков | Б |

| для питания электрооборудования экскаваторов | Э |

| для термической обработки бетона и грунта, питания ручного инструмента, временного освещения | ТО |

| шахтные трансформаторы | Ш |

| Номинальная мощность, кВА | [число] |

| Класс напряжения обмотки ВН, кВ | [число] |

| Класс напряжения обмотки СН (для авто- и трёхобмоточных тр-ов), кВ | [число] |

Примечание: принудительная циркуляция вохдуха называется дутьем, то есть «с принудительной циркуляцией воздуха» и «с дутьем» равнозначные выражения.

Примеры расшифровки наименований силовых трансформаторов

ТМ — 100/35 — трансформатор трёхфазный масляный с естественной циркуляцией воздуха и масла, номинальной мощностью 0,1 МВА, классом напряжения 35 кВ;

ТДНС — 10000/35 — трансформатор трёхфазный с дутьем масла, регулируемый под нагрузкой для собственных нужд электростанции, номинальной мощностью 10 МВА, классом напряжения 35 кВ;

ТРДНФ — 25000/110 — трансформатор трёхфазный, с расщеплённой обмоткой, масляный с принудительной циркуляцией воздуха, регулируемый под нагрузкой, с расширителем, номинальной мощностью 25 МВА, классом напряжения 110 кВ;

АТДЦТН — 63000/220/110 — автотрансформатор трёхфазный, масляный с дутьём и принудительной циркуляцией масла, трёхобмоточный, регулируемый под нагрузкой, номинальной мощностью 63 МВА, класс ВН — 220 кВ, класс СН — 110 кВ;

АОДЦТН — 333000/750/330 — автотрансформатор однофазный, масляный с дутьём и принудительной циркуляцией масла, трёхобмоточный, регулируемый под нагрузкой, номинальной мощностью 333 МВА, класс ВН — 750 кВ, класс СН — 500 кВ.

Расшифровка наименований регулировочных (вольтодобавочных) трансформаторов

Для регулировочных трансформаторов приняты следующие сокращения [1, c.238][2, c.150]:

| 1. Вольтодобавочный трансформатор | В |

| 2. Регулировочный трансформатор | Р |

| 3. Линейный регулировочный | Л |

| 4. Трёхфазный | Т |

| 5. Тип охлаждения: | |

| принудительная циркуляция воздуха и естественная циркуляция масла | Д |

| естественная циркуляция воздуха и масла | М |

| 6. Регулирование под нагрузкой (РПН) | Н |

| 7. Поперечное регулирование | П |

| 8. Грозоупорное исполнение | Г |

| 9. С усиленным вводом | У |

| Проходная мощность, кВА | [число] |

| Класс напряжения обомотки возбуждения, кВ | [число] |

| Класс напряжения регулировочной обомотки, кВ | [число] |

Примеры расшифровки наименований регулировочных трансформаторов

ВРТДНУ — 180000/35/35 — трансформатор вольтодобавочный, регулировочный, трёхфазный, с масляным охлаждением типа Д, регулируемый под нагрузкой, с усиленным вводом, проходной мощностью 180 МВА, номинальное напряжение обмотки возбуждения 35 кВ, номинальное напряжения регулировочной обмотки 35 кВ;

ЛТМН — 160000/10 — трансформатор линейный, трёхфазный, с естественной циркуляцией масла и воздуха, регулируемый под нагрузкой, проходной мощностью 160 МВА, номинальным линейным напряжением 10 кВ.

Расшифровка наименований трансформаторов напряжения

Для трансформаторов напряжения приняты следующие сокращения [2, c.200]:

| 1. Конец обмотки ВН заземляется | З |

| 2. Трансформатор напряжения | Н |

| 3. Число фаз: | |

| Однофазный | О |

| Трёхфазный | Т |

| 4. Тип изоляции: | |

| Сухая | С |

| Масляная | М |

| Литая эпоксидная | Л |

| 5. Каскадный (для серии НКФ)(1,2) | К |

| 6. В фарфоровой покрышке | Ф |

| 7. С обмоткой для контроля изоляции сети | И |

| 8. С ёмкостным делителем (серия НДЕ) | ДЕ |

| Номинальное напряжение(3), кВ | [число] |

| Климатическое исполнение | [число] |

- Примечание:

- Комплектующий для серии НОСК;

- С компенсационной обмоткой для серии НТМК;

- Кроме серии НОЛ и ЗНОЛ, в которых:

- 06 — для встраивания в закрытые токопроводы, ЗРУ и КРУ внутренней установки;

- 08 — для ЗРУ и КРУ внутренней и наружной установки;

- 11 — для взрывоопасных КРУ.

Примеры расшифровки наименований трансформаторов напряжения

НОСК-3-У5 — трансформатор напряжения однофазный с сухой изоляцией, комплектующий, номинальное напряжение обмотки ВН 3 кВ, климатическое исполнение — У5;

НОМ-15-77У1 — трансформатор напряжения однофазный с масляной изоляцией, номинальное напряжение обмотки ВН 15 кВ, 1977 года разработки, климатическое исполнение — У1;

ЗНОМ-15-63У2 — трансформатор напряжения с заземляемым концом обмотки ВН, однофазный с масляной изоляцией, номинальное напряжение обмотки ВН 15 кВ, 1963 года разработки, климатическое исполнение — У2;

ЗНОЛ-06-6У3 — трансформатор напряжения с заземляемым концом обмотки ВН, однофазный с литой эпоксидной изоляцией, для встраивания в закрытые токопроводы, ЗРУ и КРУ внутренней установки, климатическое исполнение — У3;

НТС-05-УХЛ4 — трансформатор напряжения трёхфазный с сухой изоляцией, номинальное напряжение обмотки ВН 0,5 кВ, климатическое исполнение — УХЛ4;

НТМК-10-71У3 — трансформатор напряжения трёхфазный с масляной изоляцией и компенсационной обмоткой, номинальное напряжение обмотки ВН 10 кВ, 1971 года разработки, климатическое исполнение — У3;

НТМИ-10-66У3 — трансформатор напряжения трёхфазный с масляной изоляцией и обмоткой для контроля изоляции сети, номинальное напряжение обмотки ВН 10 кВ, 1966 года разработки, климатическое исполнение — У3;

НКФ-110-58У1 — трансформатор напряжения каскадный в фарфоровой покрышке, номинальное напряжение обмотки ВН 110 кВ, 1958 года разработки, климатическое исполнение — У1;

НДЕ-500-72У1 — трансформатор напряжения с ёмкостным делителем, номинальное напряжение обмотки ВН 500 кВ, 1972 года разработки, климатическое исполнение — У1;

Расшифровка наименований трансформаторов тока

Для трансформаторов тока приняты следующие сокращения [2, c. 201,206-207,213]:

201,206-207,213]:

| 1. Трансформатор тока | Т |

| 2. В фарфоровой покрышке | Ф |

| 3. Тип: | |

| Встроенный(1) | В |

| Генераторный | Г |

| Нулевой последовательности | Н |

| Одновитковый | О |

| Проходной(2) | П |

| Усиленный | У |

| Шинный | Ш |

| 4. Исполнение обмотки: | |

| Звеньевого типа | З |

| U-образного типа | У |

| Рымочного типа | Р |

| 5. Исполнение изоляции: | |

| Литая | Л |

| Масляная | М |

6. Воздушное охлаждение(3,4) Воздушное охлаждение(3,4) | В |

| 7. Защита от замыкания на землю отдельных жил кабеля(5) | З |

| 8. Категория исполнения | А,Б |

| Номинальное напряжение(6,7) | [число] |

| Ток термической стойкости(8) | [число] |

| Климатическое исполнение | [число] |

- Примечание:

- Для серии ТВ, ТВТ, ТВС, ТВУ;

- Для серии ТНП, ТНПШ — с подмагничиванием переменным током;

- Для серии ТШВ, ТВГ;

- Для ТВВГ — 24 — водяное охлаждение;

- Для серии ТНП, ТНПШ;

- Для серии ТВ, ТВТ, ТВС, ТВУ — номинальное напряжения оборудования;

- Для серии ТНП, ТНПШ — число обхватываемых жил кабеля;

- Для серии ТНП, ТНПШ — номинальное напряжение.

Примеры расшифровки наименований трансформаторов тока

ТФЗМ — 35А — У1 — трансформатор тока в фарфоровой покрышке, с обмоткой звеньевого исполнения, с масляной изоляцией, номинальным напряжением обмотки ВН 35 кВ, категории А, климатическим исполнением У1;

ТФРМ — 750М — У1 — трансформатор тока в фарфоровой покрышке, с обмоткой рымочного исполнения, с масляной изоляцией, номинальным напряжением обмотки ВН 750 кВ, климатическим исполнением У1;

ТШЛ — 10К — трансформатор тока шинный с литой изоляцией, номинальное напряжением обмотки ВН 10 кВ;

ТЛП — 10К — У3 — трансформатор тока с литой изоляцией, проходной, номинальным напряжением обмотки ВН 10 кВ, климатическое исполнение — У3;

ТПОЛ — 10 — трансформатор тока проходной, одновитковый, с литой изоляцией, номинальным напряжением обмотки ВН 10 кВ;

ТШВ — 15 — трансформатор тока шинный, с воздушным охлаждением, номинальным напряжением обмотки ВН 15 кВ;

ТВГ — 20 — I — трансформатор тока с воздушным охлаждением, генераторный, номинальным напряжением обмотки ВН 20 кВ;

ТШЛО — 20 — трансформатор тока шинный, с литой изоляцией, одновитковый, номинальным напряжением обмотки ВН 20 кВ;

ТВ — 35 — 40У2 — трансформатор тока встроенный, номинальным напряжением обмотки ВН 35 кВ, током термической стойкости 40 кА, климатическое исполнение — У2;

ТНП — 12 — трансформатор тока нулевой последовательности, с подмагничиванием переменным током, охватывающий 12 жил кабеля;

ТНПШ — 2 — 15 — трансформатор тока нулевой последовательности, с подмагничиванием переменным током, шинный, охватывающий 2 жилы кабеля, номинальным напряжением обмотки ВН 15 кВ.

Список использованных источников

- Справочник по проектированию электрических сетей / под ред. Д.Л. Файбисовича. — 3-е изд., перераб. и доп. — Москва: ЭНАС, 2009. — 392 с.: ил.

- Справочник по электрическим установкам высокого напряжения / под ред. И.А. Баумштейна, С.А. Баженова. — 3-е изд., перераб. и доп. — Москва: Энергоатомиздат, 1989. — 768 с.: ил.

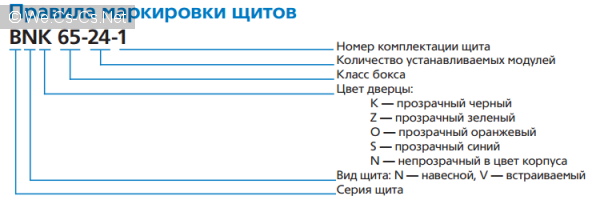

Трансформатор маркировка — Провоток

Содержание статьи

Для того, чтоб иметь какое-то понятие того, для каких условий использования подойдет конкретная разновидность трансформаторов, которая распределяет ток или напряжение, или какие-либо другие виды приборов, существует определенная маркировка трансформаторов. Обозначение у оборудования отечественного производства и зарубежного отличается. На территории нашей страны наиболее востребованными являются предметы техники, при изготовлении которых использовался стандарт качества ГОСТ.

Расположена так называемая маркировка трансформаторов на щитке на корпусе, который произведен из прочного металла. Далее в статье мы более детально ознакомимся с определенным количеством наиболее распространенных разновидностей оборудования.

Далее в статье мы более детально ознакомимся с определенным количеством наиболее распространенных разновидностей оборудования.

Знакомство с информацией

На видимой стороне представленного оборудования имеются данные, нанесение которых осуществляется одним из трех нижеперечисленных способов, таких как теснение, травление или гравировка. Каждый из представленных методов гарантирует долговечность сохранения информации. Также надпись сохраняет свою четкость на протяжении длительного периода, независимо от факторов окружающей среды и каких-либо дополнительных особенностей хранения оборудования. Информация о заводе, где было произведено оборудование, указывается на щитке, который выполнен из металла. Также там расположен год производства и заводской номер, который был присвоен оборудованию в процессе производства.

Кроме информации, которая предоставляется об производителе, в любом случае будет присутствовать информация относительно самого агрегата. Поэтому на всем оборудовании представлена номер стандарта, к которому относится само оборудование. Также обязательной для нанесения является информация о показателе номинальной мощности. Важным является наличие данных о напряжении ответвлений витков катушек.

Также обязательной для нанесения является информация о показателе номинальной мощности. Важным является наличие данных о напряжении ответвлений витков катушек.

Для каждого типа обмотки имеется определенный показатель номинального тока. Важно точно привести данные о количестве фаз для установки и частоты тока. Обязательной к предоставлению является информация о конфигурации и групп соединения катушек.

Исходя из данных, которые были приведены вашему вниманию немного выше, следует перейти к информации о трансформатор маркировка с параметрами напряжения. К установке имеются определенные требования, соблюдение которых является необходимым. Различают два типа установки трансформатора маркировка – наружную и внутреннюю.

Благодаря указанию в маркировке трансформаторов технических характеристик имеется возможность точно определиться с предполагаемым методом охлаждения оборудования, вес масла, который размещается в бачке, массу начинки, которая является активной. Возле привода переключателя имеется информация относительно его расположения. В том случае, когда в установке используется способ охлаждения сухого типа, представляются на оборудовании данные относительно мощности аппаратуры в случае отключенного вентилятора. Возле щитка в обязательном порядке выбивается заводской номер конструкции. Также эта информация имеется и на баке и возле сердечника.

В том случае, когда в установке используется способ охлаждения сухого типа, представляются на оборудовании данные относительно мощности аппаратуры в случае отключенного вентилятора. Возле щитка в обязательном порядке выбивается заводской номер конструкции. Также эта информация имеется и на баке и возле сердечника.

Особенности трансформатор маркировка

В маркировке, которая представлена на оборудовании, данные имеется возможность разбить на несколько подгрупп. Для того, чтоб не возникало путаницы в данных, следует предварительно ознакомиться с последовательностью их указания. Для написания маркировки какого-либо прибора следует принять во внимание некоторые группы:

- 1 группа А позволяет указывать тип, к которому относится прибор. То есть оборудование относится к силовому типу или является автотрансформатором.

- 2 группа Т обозначает тип сети, для которой используется рассматриваемый прибор. Наиболее распространенными являются однофазная и трехфазная.

- 3 группа ДЦ представляет собой систему охлаждения с обязательной циркуляцией масла и воздуха.

- В 4 группе Т демонстрируется численность обмоток, которая использовалась при производстве оборудования.

- 5 группа Н предназначена для демонстрации данных напряжения, регулировка которого осуществляется под нагрузкой.

- 6 группа включает в себя указание всех цифр и данных, которыми характеризуется оборудование – мощность, напряжение обмоток, особенности установки и многое другое.

Если ознакомиться с информацией о каждой из вышеуказанных категорий более детально, можно существенно проще выбрать подходящее оборудование для конкретных целей.

Существующие виды трансформатор маркировка

Независимо от каких-либо особенностей оборудования маркировка трансформаторов осуществляется в обязательном порядке с разновидности аппаратуры. В том случае, когда маркировка начинается с буквы А, это обозначает, что речь идет про автотрансформатор. Если же данная буква отсутствует, то перед вами устройство, которое относится к силовому типу.

В обязательном порядке приводится численность фаз. Благодаря этому имеется возможность отдать предпочтение оборудованию, которое работает от сети бытового или промышленного типа. В том случае, если осуществляется подключение оборудования к сети трехфазного типа, в маркировке трансформаторов вы обязательно увидите букву Т. Если же речь идет про однофазные модели, они обозначаются буквой О. Преимущественно трансформатор маркировка используется в сетях бытового предназначения.

Если принимать во внимание категорию установки, возможно использование на практике каких-либо особых обозначений. У трансформаторов напряжения или тока они могут совершенно различаться. Также различие заключается в том, что оборудование бывает защитного типа и для осуществления измерения тока. Первые используются для того, чтоб замерять значения переменного тока. Трансформаторы напряжения не применяют для осуществления передачи электрического тока, который имеет большую мощность. Главную роль в маркировке трансформаторов играют их конструкционные особенности. Конструкции, которые относятся к переходному типу, например, имеют в аббревиатуре букву П. В случае ее отсутствия перед вами оборудование опорного типа.

Конструкции, которые относятся к переходному типу, например, имеют в аббревиатуре букву П. В случае ее отсутствия перед вами оборудование опорного типа.

Купить трансформатор выгодно

Если вам требуется купить электротехническое оборудование, советуем вам посмотреть продукцию, представленную в нашем интернет-магазине. У нас имеется большой ассортиментный ряд продукции, которая в полной мере соответствуют качественным стандартам ГОСТ. Оборудование, которое представлено на сайте нашей компании, прошло тщательную проверку. Оборудование полностью соответствует заявленным характеристикам, которые указаны в пособии по эксплуатации.

На продукцию, реализацией которой мы занимаемся, предоставляется гарантия от производителя. Это дает возможность владельцу обращаться в специализированные сервисные центры нашей компании для проведения технического обслуживания или ремонта. За дополнительными консультациями обращайтесь на горячую линию нашей компании.

Измерительные трансформаторы тока: назначение, устройство, схемы

Мощные электротехнические установки могут работать с напряжением несколько сот киловольт, при этом величина тока в них может достигать более десятка килоампер. Естественно, что для измерения величин такого порядка не представляется возможным использовать обычные приборы. Даже если бы таковые удалось создать, они получились бы довольно громоздкими и дорогими.

Естественно, что для измерения величин такого порядка не представляется возможным использовать обычные приборы. Даже если бы таковые удалось создать, они получились бы довольно громоздкими и дорогими.

Помимо этого, при непосредственном подключении к высоковольтной сети переменного тока повышается риск поражения электротоком при обслуживании приборов. Избавиться от перечисленных проблем позволило применение измерительных трансформаторов тока (далее ИТТ), благодаря которым удалось расширить возможности измерительных устройств и обеспечить гальваническую развязку.

Назначение и устройство ИТТ

Функции данного типа трансформаторов заключаются в снижении первичного тока до приемлемого уровня, что делает возможным подключение унифицированных измерительных устройств (например, амперметров или электронных электросчетчиков), защитных систем и т.д. Помимо этого, трансформатор тока обеспечивают гальваническую развязку между высоким и низким напряжением, обеспечивая тем самым безопасность обслуживающего персонала. Это краткое описание позволяет понять, зачем нужны данные устройства. Упрощенная конструкция ИТТ представлена ниже.

Это краткое описание позволяет понять, зачем нужны данные устройства. Упрощенная конструкция ИТТ представлена ниже.

Обозначения:

- Первичная обмотка с определенным количеством витков (W1).

- Замкнутый сердечник, для изготовления которого используется электротехническая сталь.

- Вторичная обмотка (W2 — число витков).

Как видно из рисунка, катушка 1 с выводами L1 и L2 подключена последовательно в цепь, где производится измерение тока I1. К катушке 2 подключается приборы, позволяющие установить значение тока I2, релейная защита, система автоматики и т.д.

Основная область применения ТТ — учет расхода электроэнергии и организация систем защиты для различных электроустановок.

В измерительном трансформаторе тока обязательно наличие изоляции как между катушками, витками провода в них и магнитопроводом. Помимо этого по нормам ПУЭ и требованиям техники безопасности, необходимо заземлять вторичные цепи, что обеспечивает защиту в случае КЗ между катушками.

Получить более подробную информацию о принципе действия ТТ и их классификации, можно на нашем сайте.

Перечень основных параметров

Технические характеристики трансформатора тока описываются следующими параметрами:

- Номинальным напряжением, как правило, в паспорте к прибору оно указано в киловольтах. Эта величина может быть от 0,66 до 1150 кВ. получит полную информацию о шкале напряжений можно в справочной литературе.

- Номинальным током первичной катушки (I1), также указывается в паспорте. В зависимости от исполнения, данный параметр может быть в диапазоне от 1,0 до 40000,0 А.

- Током на вторичной катушке (I2), его значение может быть 1,0 А (для ИТТ с I1 не более 4000,0 А) или 5,0 А. Под заказ могут изготавливаться устройства с I2 равным 2,0 А или 2,50 А.

- Коэффициентом трансформации (КТ), он показывает отношение тока между первичной и вторичной катушками, что можно представить в виде формулы: КТ = I1/I2.

Коэффициент, определяемый по данной формуле, принято называть действительным. Но для расчетов еще используется номинальный КТ, в этом случае формула будет иметь вид: IНОМ1/IНОМ2, то есть в данном случае оперируем не действительными, а номинальными значениями тока на первой и второй катушке.

Коэффициент, определяемый по данной формуле, принято называть действительным. Но для расчетов еще используется номинальный КТ, в этом случае формула будет иметь вид: IНОМ1/IНОМ2, то есть в данном случае оперируем не действительными, а номинальными значениями тока на первой и второй катушке.

Ниже, в качестве примера, приведена паспортная таблица модели ТТ-В.

Перечень основных параметров измерительного трансформатора тока ТТ-ВВиды конструкций измерительных трансформаторов

В зависимости от исполнения, данные устройства делятся на следующие виды:

- Катушечные, пример такого ТТ представлен ниже. Катушечный ИТТ

Обозначения:

- A – Клеммная колодка вторичной обмотки.

- В – Защитный корпус.

- С – Контакты первичной обмотки.

- D – Обмотка (петлевая или восьмерочная) .

- Стержневые, их также называют одновитковыми. В зависимости от исполнения они могут быть:

- Встроенными, они устанавливаются на изоляторы вводы силовых трансформаторов, как показано на рисунке 4.

Рисунок 4. Пример установки встроенного ТТ

Рисунок 4. Пример установки встроенного ТТ

Обозначения:

- А – встроенный ТТ.

- В – изолятор силового ввода трансформатора подстанции.

- С – место установки ТТ (представлен в разрезе) на изоляторе. То есть, в данном случае высоковольтный ввод играет роль первичной обмотки.

- Шинными, это наиболее распространенная конструкция. Ее принцип строения напоминает предыдущий тип, стой лишь разницей, что в данном исполнении в качестве первичной обмотки используется токопроводящая шина или жила, которая заводится в окно ИТТ. Шинные ТТ производства Schneider Electric

- Разъемными. Особенность данной конструкции заключается в том, что магнитопровод ТТ может разделяться на две части, которые стягиваются между собой специальными шпильками.

Такой вариант конструкции существенно упрощает монтаж/демонтаж.

Расшифровка маркировки

Обозначение отечественных моделей интерпретируется следующим образом:

- Первая литера в названии модели указывает на вид трансформатора, в нашем случае это будет буква «Т», указывая на принадлежность к ТТ.

- Вторая литера указывает на особенность конструктивного исполнения, например, буква «Ш», говорит о том, что данное устройство шинное. Если указана литера «О», то это опорный ТТ.

- Третьей литерой шифруется исполнение изоляции.

- Цифрами указывается класс напряжения (в кВ).

- Литера, для обозначения климатического исполнения согласно ГОСТ 15150 69

- КТ, с указанием номинального тока первичной и вторичной обмотки.

Приведем пример расшифровки маркировки трансформатора тока.

Шильдик на ТТ с указанием его маркиКак видим, на рисунке изображена маркировка ТЛШ 10УЗ 5000/5А, это указывает на то, что перед нами трансформатор тока (первая литера Т) с литой изоляцией (Л) и шинной конструкцией (Ш). Данное устройство может использоваться в сети с напряжением до 10 кВ. Что касается исполнения, то литера «У», говорит о том, что аппарат создан для эксплуатации в умеренной климатической зоне. КТ 1000/5 А, указывает на величину номинального тока на первой и второй обмотке.

Схемы подключения

Обмотки трехфазных ТТ могут быть подключены «треугольником» или «звездой» (см. рис. 8). Первый вариант применяется в тех случаях, когда необходимо получить большую силу тока в цепи второй обмотки или требуется сдвинуть по фазе ток во вторичной катушке, относительно первичной. Второй способ подключения применяется, если необходимо отслеживать силу тока в каждой фазе.

Рисунок 8. Схема подключения трехобмоточного ТТ «звездой» и «треугольником»При наличии изолированной нейтрали, может использоваться схема для измерения разности токов между двумя фазами (см. А на рис. 9) или подключение «неполной звездой» (B).

Рисунок 9. Схема подключения ТТ на разность двух фаз (А) и неполной звездой (В)Когда необходимо запитать защиту от КЗ на землю, применяется схема, позволяющая суммировать токи всех фаз (см. А на рис 10.). Если к выходу такой цепи подключить реле тока, то оно не будет реагировать на КЗ между фазами, но обязательно сработает, если происходит пробой на землю.

В завершении приведем еще два примера соединения вторичных обмоток ТТ для снятия показаний с одной фазы:

Вторичные катушки включаются последовательно (В на рис. 10), благодаря этому возникает возможность измерения суммарной мощности.

Вторичные обмотки соединяются параллельно, что дает возможность понизить КТ, поскольку происходит суммирование тока в этих катушках, в то время как в линии этот показатель остается без изменений.

Выбор

При выборе трансформатора тока в первую очередь необходимо учитывать номинальное напряжение прибора было не ниже, чем в сети, где он будет установлен. Например, для трехфазной сети с напряжением 380 В можно использовать ТТ с классом напряжения 0,66 кВ, соответственно для установок более 1000 В, устанавливать такие устройства нельзя.

Помимо этого IНОМ ТТ должен быть равен или превышать максимальный ток установки, где будет эксплуатироваться прибор.

Кратко изложим и другие правила, позволяющие не ошибиться с выбором ТТ:

- Сечение кабеля, которым будет подключаться ТТ к цепи вторичной нагрузки, не должно приводить к потерям сверх допустимой нормы (например, для класса точности 0,5 потери не должны превышать 0,25%).

- Для систем коммерческого учета должны использоваться устройства с высоким классом точности и низким порогом погрешности.

- Допускается установка токовых трансформаторов с завышенным КТ, при условии, что при максимальной нагрузке ток будет до 40% от номинального.

Посмотреть нормы и правила, по которым рассчитываются измерительные трансформаторы тока (в том числе и высоковольтные) можно в ПУЭ ( п.1.5.1.). Пример расчета показан на картинке ниже.

Пример расчета трансформатора токаЧто касается выбора производителя, то мы рекомендуем использовать брендовую продукцию, достоинства которой подтверждены временем, например ABB, Schneider Electric b и т.д. В этом случае можно быть уверенным, что указанные в паспорте технические данные, а методика испытаний соответствовала нормам.

Обслуживание

Необходимо обратить внимание, что при соблюдении режима и условий эксплуатации, правильно подобранных номиналах и регулярном обслуживании ТТ будет служить 30 лет и более. Для этого необходимо:

- Обращать внимание на различные виды неисправностей, заметим, что большинство из них можно обнаружить при визуальном осмотре.

- Производить контроль нагрузки в первичных цепях и не допускать перегрузку выше установленной нормы.

- Необходимо отслеживать состояние контактов первичной цепи (если таковые имеются), на них должны отсутствовать внешние признаки повреждений.

- Не менее важен контроль состояния внешней изоляции, почти в половине случаев ее стойкость нарушается из-за скопления грязи или влаги, которые закорачивают контакты на землю.

- У масляных ТТ осуществляют проверку уровня масла, его чистоту, наличие подтеков и т.д. Обслуживание таких установок практически не сильно отличается от других силовых установок, например, емкостных трансформаторов НДЕ, разница заключается в небольших технических деталях.

- Поверка ТТ должна проводиться согласно действующих нормативов (ГОСТ 8.217 2003).

- При обнаружении неисправности производится замена прибора. Поврежденный ТТ отправляют в ремонт, который производится специализированными службами.

Использованная литература

- В.В. Афанасьев «Трансформаторы тока» 1989

- И С. Таев «Основы теории электрических аппаратов» 1987

- Вавин В. Н. «Трансформаторы тока» 1966

- Кацман М. М. «Электрические машины и трансформаторы» 1971

Трансформатор тока Т 0-66 ТШ 0-66

Предназначены для пропорционального изменения уровня измеряемого тока и передаче сигнала измеряющему оборудовании в сетях переменного тока частотой 50 Гц и номинальным напряжением до 0,66 кВт. Измерительные трансформатор ы Т-0-66 широко используются совместно с трехфазными счетчиками электроэнергии и щитовыми амперметрами. Поключение трансформаторов к счетчикам идет через испытательную колодку ИКК проводом ПВ 3 *2,5

Основные характеристики трансформаторов Т-0-66.

1. Максимальный уровень измеряемого тока в первичной обмотке.

2. Коэффициент трансформации– соотношения первоначального уровня измеряемого тока и уровень тока во вторичной обмотке.

3. Класс точности трансформатора- максимальная относительная погрешность при трансформации уровня измеряемого сигнала.

4. Способ подключения к проводнику

А) путем подключения к шине или кабелю с помощью винтов — катушечный трансформатор

Б) Трансформатор одевает на шину –шинный.

5. Климатическое исполнение У3 – в зонах умеренного климата, в помещениях защищенных с искусственно регулируемой температурой.

Особенности трансформатор Т-0-66

Имеют защитную пломбу в местах вывода вторичной обмотки с печатью поверяющей организации. Корпус трансформаторов выполняется из электротехнической пластмассы, по спец заказу возможно изготовление из само затухающей пластмассы.

Катушечные трансформаторы Т-0-66 устанавливаются на заземленную поверхность с помощью фланцевых соединений или винтов. Шинные трансформаторы ТШ-0-66 устанавливается на шине

Шинные трансформаторы ТШ-0-66 устанавливается на шине

Конструкция трансформаторов представляет собой на тороидальном магнитопроводе из электротехнической стали намотана медная эмалированная проволока и алюминиевая проволока первичной обмотки. Сердечник обмоток пропитан электроизоляционным лаком, класс нагревостойкости E

Расшифровка обозначений серии Т-0 66, ТШ 0-66

трансформатор Т-0,66, ТШ-0,66 ХХ/Х Х ХХ

Т трансформатор тока опроный

ТШ трансформатор тока шинный

0,66 номинальное напряжения 0,66кВ

ХХ напряжение первичной обмотки

Х напряжение вторичной обмотки

ХХ номинальная мощность

ХХ класс точности

без буквы производство Самарского завода «Электрощит»

М производство «ЭЛТИ», Кострома

Вопросы и ответы по серии Т-0 66, ТШ 0-66

- Сергей спрашивает:

К какому типу трансформаторов «шинному» или «опорному» относятся представленные у Вас на сайте трансформаторы Т 0,66?

- Ответ технического специалиста:

Трансформаторы Т 0,66 производства Элти до номинала 200А относятся к опроным трансформаторам (шина жестко встроена в корпус), выше 200А Т 0,66 имеют универсальную конструкцию.

Шина вставлена в корпус трансформатора и закреплена с помощью болта. При необходимости шина легко удаляется.

Шина вставлена в корпус трансформатора и закреплена с помощью болта. При необходимости шина легко удаляется. - Сергей Анатольевич спрашивает:

Можно ли использовать трансфоматор тока Т 0,66 200/5, а амперметр с Ктр=300/5, это как-то влияет на показания измерения?

- Ответ технического специалиста:

Использовать то конечно можно, только амперметр будет нпоказывать неверные показания с КТР 1,5.))

Иллюстрированное руководство по трансформаторам — пошаговое объяснение | Майкл Фи

Трансформаторы штурмом захватывают мир обработки естественного языка. Эти невероятные модели бьют множество рекордов НЛП и продвигают новейшие разработки. Они используются во многих приложениях, таких как машинный перевод, разговорные чат-боты и даже для улучшения поисковых систем. Трансформаторы сейчас в моде в области глубокого обучения, но как они работают? Почему они превзошли предыдущего короля проблем последовательности, такого как рекуррентные нейронные сети, GRU и LSTM? Вы, наверное, слышали о различных известных моделях трансформеров, таких как BERT, GPT и GPT2. В этом посте мы сосредоточимся на одной статье, с которой все началось: «Внимание — это все, что вам нужно».

В этом посте мы сосредоточимся на одной статье, с которой все началось: «Внимание — это все, что вам нужно».

Перейдите по ссылке ниже, если вы хотите вместо этого посмотреть видеоверсию.

Чтобы понять трансформаторов, мы сначала должны понять механизм внимания. Механизм внимания позволяет трансформаторам иметь чрезвычайно долгую память. Модель-трансформер может «присутствовать» или «фокусироваться» на всех ранее сгенерированных токенах.

Давайте рассмотрим пример. Допустим, мы хотим написать небольшой научно-фантастический роман с генеративным преобразователем.Мы можем сделать это с помощью приложения Write With Transformer от Hugging Face. Мы заполним модель нашими входными данными, а модель сгенерирует все остальное.

Наш вклад: «Когда пришельцы вошли на нашу планету».

Выход трансформатора: «и начала колонизацию Земли, определенная группа инопланетян начала манипулировать нашим обществом через свое влияние определенного числа элиты, чтобы удерживать и железной хваткой над населением».

Хорошо, история немного мрачная, но интересно то, как модель ее сгенерировала.По мере того как модель генерирует текст слово за словом, она может «следить» или «фокусироваться» на словах, которые имеют отношение к сгенерированному слову. Способность знать, какие слова следует посещать, тоже приобретается во время обучения посредством обратного распространения ошибки.

Механизм внимания, фокусирующийся на разных токенах при генерации слов 1 на 1 Рекуррентные нейронные сети (RNN) также могут просматривать предыдущие входные данные. Но сила механизма внимания в том, что он не страдает от кратковременной памяти. У RNN более короткое окно для ссылки, поэтому, когда история становится длиннее, RNN не может получить доступ к словам, сгенерированным ранее в последовательности.Это по-прежнему верно для сетей Gated Recurrent Units (GRU) и Long-Short Term Memory (LSTM), хотя они обладают большей емкостью для достижения более долгосрочной памяти, следовательно, имеют более длительное окно для ссылки. Механизм внимания теоретически и при наличии достаточных вычислительных ресурсов имеет бесконечное окно, из которого можно ссылаться, поэтому он может использовать весь контекст истории при создании текста.

Механизм внимания теоретически и при наличии достаточных вычислительных ресурсов имеет бесконечное окно, из которого можно ссылаться, поэтому он может использовать весь контекст истории при создании текста.

Сила механизма внимания была продемонстрирована в статье «Внимание — это все, что вам нужно», где авторы представили новую новую нейронную сеть под названием Transformers, которая является кодировщиком на основе внимания. архитектура типа декодера.Модель преобразователя

На высоком уровне кодер преобразует входную последовательность в абстрактное непрерывное представление, которое содержит всю изученную информацию этого входа. Затем декодер принимает это непрерывное представление и шаг за шагом генерирует один вывод, одновременно получая предыдущий вывод.

Давайте рассмотрим пример. В статье модель Transformer применялась к задаче нейронного машинного перевода. В этом посте мы продемонстрируем, как это работает для разговорного чат-бота.

Наш ввод: «Привет, как дела»

Вывод трансформатора: «Я в порядке»

Первым шагом является подача ввода в слой встраивания слов. Слой встраивания слов можно рассматривать как таблицу поиска, чтобы получить изученное векторное представление каждого слова. Нейронные сети обучаются с помощью чисел, поэтому каждое слово отображается в вектор с непрерывными значениями для представления этого слова.

преобразование слов во входные вложенияСледующим шагом является введение позиционной информации во вложения.Поскольку кодировщик-преобразователь не имеет повторения, как рекуррентные нейронные сети, мы должны добавить некоторую информацию о позициях во входные вложения. Это делается с помощью позиционного кодирования. Авторы придумали хитрый трюк, используя функции sin и косинус.

Мы не будем вдаваться в математические подробности позиционного кодирования, но вот основы. Для каждого нечетного индекса входного вектора создайте вектор с помощью функции cos. Для каждого четного индекса создайте вектор с помощью функции sin.Затем добавьте эти векторы к их соответствующим входным вложениям. Это успешно дает сети информацию о положении каждого вектора. Функции sin и косинус были выбраны в тандеме, потому что они обладают линейными свойствами, которым модель может легко научиться уделять внимание.

Для каждого четного индекса создайте вектор с помощью функции sin.Затем добавьте эти векторы к их соответствующим входным вложениям. Это успешно дает сети информацию о положении каждого вектора. Функции sin и косинус были выбраны в тандеме, потому что они обладают линейными свойствами, которым модель может легко научиться уделять внимание.

Теперь у нас есть слой кодировщика. Задача слоев Encoders состоит в том, чтобы отобразить все входные последовательности в абстрактное непрерывное представление, которое содержит изученную информацию для всей этой последовательности. Он содержит 2 подмодуля, многоголовое внимание, за которым следует полностью подключенная сеть.Также существуют остаточные связи вокруг каждого из двух подслоев, за которыми следует нормализация уровня.

Субмодули уровня кодировщикаЧтобы разобраться в этом, давайте сначала рассмотрим модуль многоголового внимания.

Многоголовое внимание в кодировщике применяет особый механизм внимания, называемый самовниманием. Самовнимание позволяет моделям связывать каждое слово во входных данных с другими словами. Итак, в нашем примере наша модель может научиться ассоциировать слово «вы» с «как» и «есть».Также возможно, что модель узнает, что слова, структурированные по этому шаблону, обычно являются вопросом, поэтому отвечайте соответствующим образом.

Самовнимание позволяет моделям связывать каждое слово во входных данных с другими словами. Итак, в нашем примере наша модель может научиться ассоциировать слово «вы» с «как» и «есть».Также возможно, что модель узнает, что слова, структурированные по этому шаблону, обычно являются вопросом, поэтому отвечайте соответствующим образом.

Векторы запросов, ключей и значений

Чтобы добиться самовнимания, мы передаем входные данные в 3 отдельных полностью связанных слоя для создания векторов запроса, ключа и значения.

Что именно это за векторы? Я нашел хорошее объяснение по обмену стеками, в котором говорится….

«Концепция ключа и значения запроса исходит из поисковых систем. Например, когда вы вводите запрос для поиска некоторого видео на Youtube, поисковая система сопоставляет ваш запрос с набором ключей (заголовок видео, описание и т.

Д.), Связанных с видео кандидатов в базе данных, затем представим вам наиболее подходящие видео ( значения ).

Точечное произведение запроса и ключа

После подачи вектора запроса, ключа и значения через линейный слой запросы и ключи подвергаются умножению матрицы скалярного произведения для создания матрицы оценок.

Умножение скалярного произведения запроса и ключаМатрица оценок определяет, насколько большое внимание следует уделять слову другие слова. Таким образом, каждое слово будет иметь оценку, соответствующую другим словам на временном шаге. Чем выше оценка, тем больше внимания. Вот как запросы сопоставляются с ключами.

Оценка внимания от скалярного произведения.Уменьшение оценок внимания

Затем оценки уменьшаются путем деления на квадратный корень из измерения запроса и ключа.Это сделано для обеспечения более стабильных градиентов, так как умножение значений может иметь взрывной эффект.

Softmax масштабированных оценок

Затем вы берете softmax масштабированной оценки, чтобы получить веса внимания, что дает вам значения вероятности от 0 до 1. Выполняя softmax, повышаются более высокие оценки, и более низкие баллы подавлены. Это позволяет модели быть более уверенной в выборе слов.

Взятие softmax масштабированных оценок для получения значений вероятностиУмножение выходных данных Softmax на вектор значений

Затем вы берете веса внимания и умножаете их на свой вектор значений, чтобы получить вектор выходных данных.Более высокие баллы softmax сохранят ценность слов, которые модель выучила более важными. Более низкие баллы заглушают неуместные слова. Затем вы передаете результат в линейный слой для обработки.

Чтобы сделать это вычисление многоголового внимания, вам необходимо разделить запрос, ключ и значение на N векторов, прежде чем применять самовнимание. Затем расщепленные векторы индивидуально проходят процесс самовнимания. Каждый процесс самовнимания называется головой. Каждая голова создает выходной вектор, который объединяется в один вектор перед прохождением последнего линейного слоя.Теоретически каждая голова будет изучать что-то свое, что дает модели кодировщика больше возможностей представления.

Каждый процесс самовнимания называется головой. Каждая голова создает выходной вектор, который объединяется в один вектор перед прохождением последнего линейного слоя.Теоретически каждая голова будет изучать что-то свое, что дает модели кодировщика больше возможностей представления.

Подводя итог, многоголовое внимание — это модуль в трансформаторной сети, который вычисляет веса внимания для входа и создает выходной вектор с закодированной информацией о том, как каждое слово должно соответствовать всем другим словам в последовательности.

Выходной вектор многоголового внимания добавляется к исходному позиционному входному встраиванию.Это называется остаточной связью. Вывод остаточного соединения проходит через нормализацию слоя.

Остаточное соединение позиционного встраивания ввода и вывода многоголового внимания Нормализованный остаточный вывод проецируется через точечную сеть с прямой связью для дальнейшей обработки. Точечная сеть с прямой связью представляет собой пару линейных слоев с активацией ReLU между ними. Выходной сигнал затем снова добавляется к входу точечной сети с прямой связью и далее нормализуется.

Точечная сеть с прямой связью представляет собой пару линейных слоев с активацией ReLU между ними. Выходной сигнал затем снова добавляется к входу точечной сети с прямой связью и далее нормализуется.

Остаточные соединения помогают обучению сети, позволяя градиентам проходить через сети напрямую. Нормализация слоев используется для стабилизации сети, что приводит к существенному сокращению необходимого времени обучения. Слой точечной упреждающей связи используется для проецирования выходных данных внимания, потенциально давая им более богатое представление.

Это завершает слой кодировщика. Все эти операции предназначены для кодирования входных данных в непрерывное представление с информацией о внимании.Это поможет декодеру сосредоточиться на соответствующих словах во вводе во время процесса декодирования. Вы можете складывать кодер N раз для дальнейшего кодирования информации, при этом каждый уровень имеет возможность изучать различные представления внимания, что потенциально увеличивает предсказательную мощность трансформаторной сети.

Задача декодера — генерировать текстовые последовательности. Декодер имеет такой же подуровень, что и кодер. он имеет два многоголовых уровня внимания, слой с точечной прямой связью и остаточные связи, а также нормализацию уровня после каждого подуровня.Эти подуровни ведут себя аналогично уровням в кодировщике, но каждый многоглавый уровень внимания выполняет свою работу. Декодер завершается линейным слоем, который действует как классификатор, и softmax для получения вероятностей слов.

Слой декодера. Ссылка на эту диаграмму при чтении.Декодер является авторегрессионным, он начинается со стартового токена и принимает список предыдущих выходов в качестве входов, а также выходы кодировщика, которые содержат информацию о внимании из входа.Декодер прекращает декодирование, когда генерирует токен в качестве вывода.

Декодер является авторегрессионным, так как он генерирует маркер 1 за раз, подавая его на предыдущие выходы. Давайте пройдемся по этапам декодирования.

Начало декодера почти такое же, как и у кодировщика. Входные данные проходят через слой внедрения и слой позиционного кодирования, чтобы получить позиционные вложения. Позиционные вложения вводятся в первый слой внимания с несколькими головами, который вычисляет оценки внимания для входных данных декодера.

Этот многоглавый слой внимания работает несколько иначе. Поскольку декодер является авторегрессионным и генерирует последовательность слово за словом, вам необходимо предотвратить его преобразование в будущие токены. Например, при вычислении оценки внимания к слову «я» у вас не должно быть доступа к слову «отлично», потому что это слово является будущим словом, которое было сгенерировано после. Слово «am» должно иметь доступ только к самому себе и к словам перед ним. Это верно для всех других слов, где они могут относиться только к предыдущим словам.

Изображение первого многоголового внимания декодера по шкале оценки внимания. Слово «am» не должно иметь никакого значения для слова «штраф». Это верно для всех остальных слов.

Это верно для всех остальных слов.Нам нужен метод, предотвращающий вычисление оценок внимания для будущих слов. Этот метод называется маскировкой. Чтобы декодер не смотрел на будущие токены, вы применяете маску просмотра вперед. Маска добавляется перед вычислением softmax и после масштабирования оценок. Давайте посмотрим, как это работает.

Маска упреждения

Маска — это матрица того же размера, что и оценки внимания, заполненная значениями 0 и отрицательной бесконечностью.Когда вы добавляете маску к шкале оценок внимания, вы получаете матрицу оценок, в которой верхний правый треугольник заполнен бесконечностями негатива.

Добавление маски упреждающего просмотра к масштабированным оценкам Причина использования маски в том, что как только вы берете softmax замаскированных оценок, отрицательные бесконечности обнуляются, оставляя нулевые оценки внимания для будущих токенов. Как вы можете видеть на рисунке ниже, оценка внимания для «am» имеет значения для себя и всех слов перед ним, но равна нулю для слова «хорошо». По сути, это говорит модели не акцентировать внимание на этих словах.

По сути, это говорит модели не акцентировать внимание на этих словах.

Это маскирование — единственное отличие в том, как рассчитываются оценки внимания в первом многоглавом слое внимания. Этот слой по-прежнему имеет несколько головок, к которым применяется маска, прежде чем они будут объединены и пропущены через линейный слой для дальнейшей обработки. Результатом первого многоголового внимания является замаскированный выходной вектор с информацией о том, как модель должна присутствовать на входе декодера.

Многоголовое внимание с маскированиемВторой слой многоголового внимания.Для этого уровня выходными данными кодировщика являются запросы и ключи, а выходными данными первого многоголового уровня внимания являются значения. Этот процесс сопоставляет вход кодера со входом декодера, позволяя декодеру решить, на какой вход кодера следует обратить внимание. Выход второго многоголового внимания проходит через точечный слой прямой связи для дальнейшей обработки.

Выходные данные последнего поточечного слоя с прямой связью проходят через последний линейный слой, который действует как классификатор. Классификатор такой же большой, как и количество имеющихся у вас классов. Например, если у вас есть 10 000 классов для 10 000 слов, вывод этого классификатора будет иметь размер 10 000. Выходные данные классификатора затем передаются в слой softmax, который дает оценки вероятности от 0 до 1. Мы берем индекс наивысшей оценки вероятности, который равен нашему предсказанному слову.

Классификатор такой же большой, как и количество имеющихся у вас классов. Например, если у вас есть 10 000 классов для 10 000 слов, вывод этого классификатора будет иметь размер 10 000. Выходные данные классификатора затем передаются в слой softmax, который дает оценки вероятности от 0 до 1. Мы берем индекс наивысшей оценки вероятности, который равен нашему предсказанному слову.

Затем декодер берет вывод, добавляет его в список входов декодера и снова продолжает декодирование, пока не будет предсказан токен.В нашем случае предсказание с наивысшей вероятностью — это последний класс, который назначается конечному токену.

Декодер также может быть наложен на N уровней, каждый из которых принимает входные данные от кодера и предшествующих ему слоев. Сложив слои, модель может научиться извлекать и сосредотачиваться на различных комбинациях внимания из своих головок внимания, потенциально повышая ее способность к прогнозированию.

И все! Такова механика трансформаторов.Трансформаторы используют силу механизма внимания, чтобы делать более точные прогнозы. Рекуррентные нейронные сети пытаются добиться аналогичных результатов, но потому, что страдают от кратковременной памяти. Трансформаторы могут быть лучше, особенно если вы хотите кодировать или генерировать длинные последовательности. Благодаря архитектуре преобразователя индустрия обработки естественного языка может достичь беспрецедентных результатов.

Посетите michaelphi.com, чтобы найти больше подобного контента.

Трансформеры в НЛП: объяснение для новичков

Или, как я люблю называть это «Внимание на стероидах».💉💊

Фото Арсения Тогулева на UnsplashНет, эта статья не про американский научно-фантастический боевик — здесь нет Оптимуса Прайма. Речь также не идет об электрическом устройстве, которое используется для передачи энергии от одной электрической цепи к другой. Вы спросите, о чем это?

Это одна из самых научно-фантастических областей всех времен, в частности, искусственный интеллект — обработка естественного языка, и она довольно оптимальна для передачи информации и широко используется. (Посмотрите, что я там сделал.: P)

(Посмотрите, что я там сделал.: P)

Этот пост основан на статье: «Внимание — это все, что вам нужно». P.S. авторы не шутили, когда выбрали это название, потому что для этого вам понадобится все внимание, которое есть в вашем распоряжении. Но пусть это вас не пугает, оно ТАК того стоит !!

Преобразователь в NLP — это новая архитектура , которая нацелена на решение задач от последовательности к последовательности с легкостью обработки дальнодействующих зависимостей. Он полностью полагается на собственное внимание при вычислении представлений своего ввода и вывода БЕЗ с использованием выровненных по последовательности RNN или свертки.🤯

Если вы помните мой предыдущий пост «Понимание внимания в глубоком обучении», мы обсуждали, как и почему многие модели терпят неудачу, когда дело доходит до обработки дальнодействующих зависимостей. Концепция внимания в некоторой степени позволила нам преодолеть эту проблему, и теперь в Transformers мы будем опираться на внимание и раскрывать весь его потенциал.

Самовнимание

Давайте начнем с повторного рассмотрения того, какое внимание уделяется вселенной НЛП? Понимание внимания в глубоком обучении. ( Прошу прощения за эту вопиющую саморекламу, но внимательно прочтите ее.Это поможет вам намного лучше под Трансформеры. Я обещаю. )

Внимание позволило нам сосредоточиться на частях нашей входной последовательности, пока мы предсказывали нашу выходную последовательность . Если наша модель предсказала слово « rouge » [французский перевод красного цвета], мы, скорее всего, найдем высокий возраст веса для слова « red » во входной последовательности. Таким образом, внимание, в некотором смысле, позволило нам отобразить некоторую связь / корреляцию между входным словом « rouge » и выходным словом « red ».

Собственное внимание , иногда называемое внутренним вниманием, — это механизм внимания, связывающий различные позиции одной последовательности для вычисления представления последовательности.

Проще говоря, самовнимание помогает нам создавать похожие связи, но в рамках одного предложения. Посмотрите на следующий пример:

«Я налил воду из бутылки в чашку до она была полная .«

it => чашка« Я наливал воду из бутылки в чашку, пока она не стала пустой ».

it => bottle

При изменении одного слова « full » -> « empty » объект ссылки на « it » изменился. Если мы переводим такое предложение, нам нужно знать, к чему относится слово « это ».

В модели возможны три вида внимания:

- Кодер-декодер Внимание : Внимание между входной и выходной последовательностями.

- Собственное внимание во входной последовательности : Обращает внимание на все слова во входной последовательности.

- Собственное внимание в выходной последовательности: Одна вещь, о которой нам следует опасаться, — это то, что сфера самовнимания ограничена словами, которые встречаются перед данным словом. Это предотвращает любые утечки информации во время обучения модели. Это делается путем маскировки слов, следующих после него, для каждого шага. Таким образом, на шаге 1 НЕ маскируется только первое слово выходной последовательности, на шаге 2 первые два слова НЕ маскируются и так далее.

Ключи, значения и запросы:

Три случайных слова, которые я только что сказал вам в этом заголовке, — это векторы, созданные как абстракции, полезные для расчета самовнимания, подробнее о каждом ниже. Они вычисляются путем умножения вашего входного вектора ( X ) на весовые матрицы, которые изучаются во время тренировки.

- Вектор запроса : q = X * Wq. Считайте это текущим словом.

- Вектор ключа : k = X * Wk.

Думайте об этом как о механизме индексации вектора значений. Подобно тому, как у нас есть пары ключ-значение в хэш-картах, где ключи используются для однозначной индексации значений.

Думайте об этом как о механизме индексации вектора значений. Подобно тому, как у нас есть пары ключ-значение в хэш-картах, где ключи используются для однозначной индексации значений. - Вектор значений: v = X * Wv. Думайте об этом как об информации во входном слове.